Il y a quelques mois je publiais un comparatif de 15 services de recherche assistés par IA. Ces outils combinent un moteur de recherche traditionnel, permettant d’aller chercher des résultats, et un modèle de langage (LLM) capable de les organiser et de les mettre en forme. C’est ce que l’on appelle un fonctionnement en mode RAG.

Où en sommes nous un an plus tard ? Et bien on peut dire que les choses sont allées vite et que ce n’est probablement qu’un avant-goût des bouleversements à venir. Le moment semble donc idéal pour tenter d’éclairer la direction prise par la recherche web et de tenter ainsi d’anticiper les changements.

Qui sera concerné par les évolutions que nous allons évoquer ? Au premier abord, on aurait envie de dire « tous ceux qui recherchent de l’info en ligne », mais rendons-nous à l’évidence, après plus de vingt ans à tenter d’expliquer le bon usage des moteurs de recherche, force est de constater que ceux que le sujet intéresse vraiment sont peu nombreux : veilleurs, osinters, enquêteurs, journalistes, factcheckers et plus globalement, spécialistes de l’investigation en ligne.

Notez que je n’aborderai pas cette question sous l’angle du référencement, qui n’est pas mon domaine d’expertise. Je précise néanmoins que les conséquences des évolutions en SEO relatives à l’IA (parce que c’est là qu’il y a de l’argent à gagner), vont inévitablement influencer les interfaces et les méthodes de recherche, et pas dans dix ans…

Des moteurs de recherche aux moteurs de réponse

Les services les plus avancés, comme Perplexity.ai, ChatGPT Web Search, Bing Copilot ou Brave Search, transforment déjà la manière dont nous recherchons l’information. Ainsi, Gartner prévoit une baisse de 25 % du trafic des moteurs de recherche traditionnels d’ici 2026 au profit des moteurs de réponse générative.

Ces outils privilégient les réponses directes et contextualisées et marquent une vraie rupture avec les moteurs de recherche traditionnels, que ce soit dans la manière de les interroger, puisqu’on troque les opérateurs booléens et de ciblage contre le langage naturel, ou dans le type de réponses qu’ils fournissent, puisque l’on passe d’une liste de liens cliquables à des réponses rédigées. Nous sommes donc en train de basculer des « moteurs de recherche » aux « moteurs de réponse ». Un objectif de longue date pour Google, que l’on peut désormais considérer comme atteint.

Bien entendu, le changement le plus évident est le fait de pouvoir se passer d’opérateurs booléens et de ciblage et de rechercher en langage naturel. En retour, il faut apprendre à prompter un minimum, mais nous verrons que même cela est en train d’évoluer.

Comment fonctionne une recherche assistée par IA

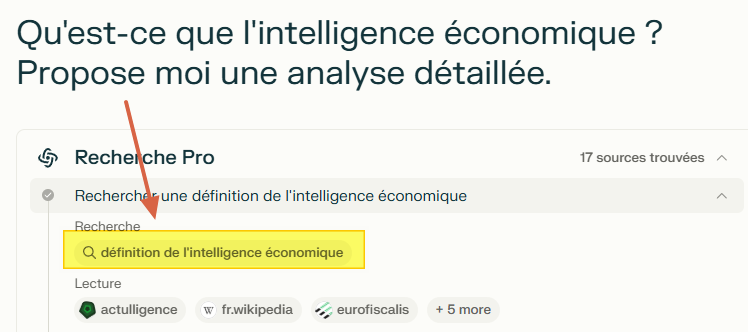

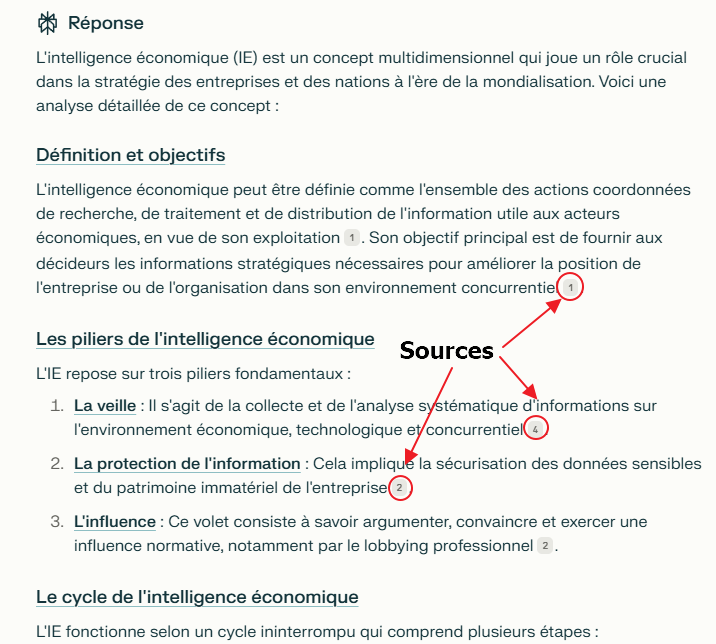

Concrètement, les étapes d’une requête dans un de ces services sont les suivantes :

1. L’utilisateur pose une question en langage naturel.

2. Le service de recherche assisté par IA (ici Perplexity) interprète la question via un LLM, ce qui veut dire qu’il la transforme en une ou plusieurs requêtes.

3. Le système lance cette requête dans le moteur de recherche qu’il utilise (Bing, Google, Brave,…).

4. Il extrait des pages de résultat remontées les éléments de réponse à la question initiale.

5. Il formate la réponse en une synthèse mentionnant les sources utilisées.

Si Perplexity est resté longtemps (deux ans…) la référence incontournable dans ce domaine, ce n’est clairement plus le cas avec le lancement de Gemini Deep Research (payant) en décembre dernier.

Au lancement de ChatGPT, fin 2022, Google avait été pris de cours et avait piétiné durant quelques mois, mais ce n’était qu’une question de temps avant que l’entreprise ne comble son retard et déploie la vaste infrastructure qu’elle préparait depuis longtemps. Rappelons en effet que l’émergence des LLM trouve en grande partie sa source dans une publication clé des équipes de recherche de Google, datant de 2017.

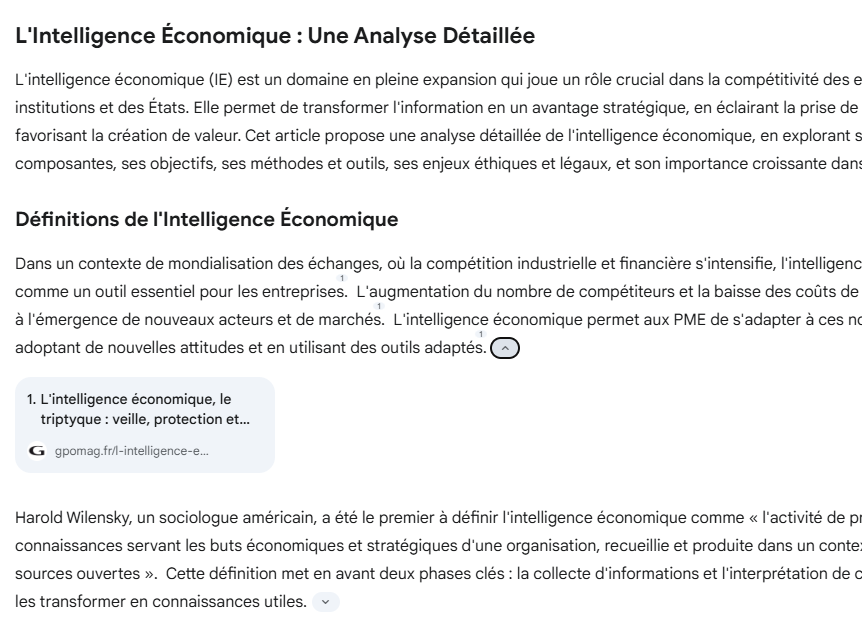

L’atout majeur de Gemini Deep Research réside bien sûr dans son accès direct à l’index de Google. Contrairement à Perplexity qui utilise l’API de Bing de manière probablement limitée (10 à 20 résultats exploités par requêtes), Gemini exploite librement les résultats de Google pouvant analyser jusqu’à une centaine de sources pour générer ses réponses. Cela lui permet de produire des synthèses non seulement plus détaillées, mais également plus nuancées que celles de ses concurrents. Voici par exemple la réponse fournie à la même question que ci-dessus.

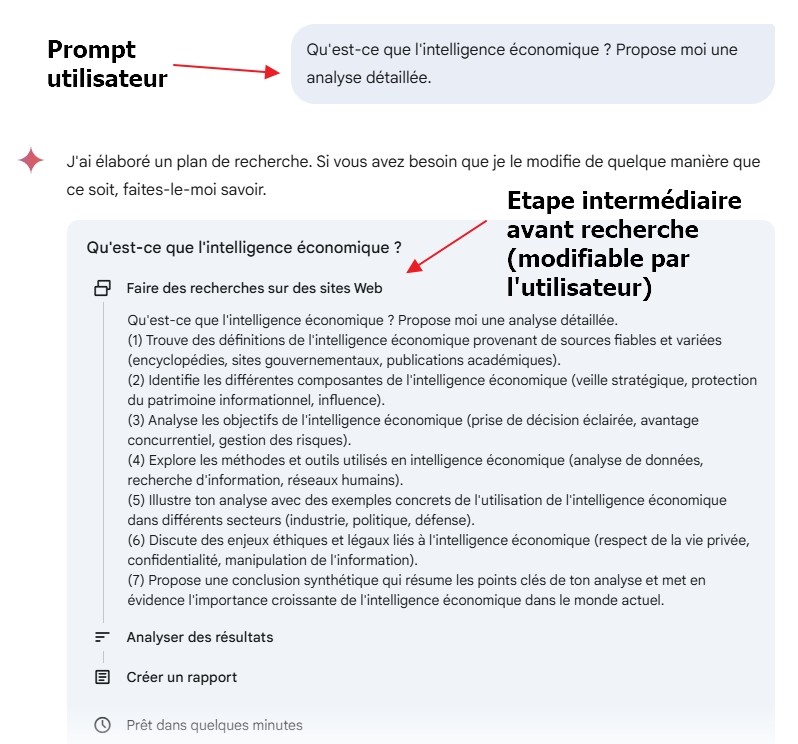

L’un des aspects les plus innovants de Gemini Deep Research réside dans la phase intermédiaire qu’il propose : un plan de recherche détaillé qui expose les étapes qu’il envisage de suivre pour répondre à notre question et qui peut être ajusté par l’utilisateur avant le lancement de la recherche.

Risques et limites de la recherche assistée par IA pour l’investigation

Si vous avez pris le temps de parcourir la synthèse générée par Gemini à partir de ce prompt très simple, vous aurez probablement été impressionné (j’avoue, je le suis !) par la qualité de la réponse. Structurée et pertinente, elle s’appuie sur une trentaine de sources variées, y compris des publications scientifiques (cf. la liste en fin de document).

Si la recherche documentaire et la synthèse d’information étaient nos seuls usages des moteurs de recherche, cette avancée serait quasi révolutionnaire et probablement irréversible. Ajoutez à cela la possibilité de transformer ces requêtes en alertes et d’obtenir des synthèses mises à jour automatiquement, comme le propose déjà ChatGPT, et le jeu serait plié.

Sauf que… si ces usages peuvent éventuellement se concevoir dans le cadre d’un travail de veille, ils sont loin d’être adaptés aux recherches ponctuelles effectuées par tous les métiers cités plus haut. L’osinter, le factchecker, le détective ont besoin de trouver l’indice, le détail, la petite info, le document spécifique qui, cumulé à d’autres, leur permettra de faire avancer leur investigation, ou a minima, d’émettre, de confirmer ou d’infirmer des hypothèses de travail.

Or, ce n’est pas du tout ce que permettent ces outils. Bien qu’ils indiquent leurs sources, leur mode de sélection de celles-ci reste totalement opaque. Là où nous parvenions encore à « forcer » Google à nous livrer des résultats précis grâce aux opérateurs avancés, Google/Gemini limite dorénavant notre contrôle sur les résultats obtenus.

Le risque ? Que Google (et les autres moteurs traditionnels) décident de supprimer tous les opérateurs qui permettent aux professionnels de la recherche d’information de « creuser le web ». Comment, en effet, rechercher un PDF dont le titre comporte l’expression intelligence économique sur les sites gouvernementaux français si l’on ne dispose plus d’opérateurs de recherche adaptés ?

L’objectif ici n’est pas d’inquiéter outre mesure les chercheurs d’information en ligne, mais bien de les mettre en garde sur les risques de disparition potentielle des méthodes que nous utilisions depuis… 25 ans.

Qu’une nouvelle ère s’ouvre enfin pour l’investigation est particulièrement enthousiasmant, mais il ne faudrait pas que cela se fasse au détriment de la qualité de ce que l’on peut obtenir. Nous n’avons évidemment pas la main. Reste donc à attendre ce que les équipes de Google nous réservent après que Sundar Pichai, PDG d’Alphabet, ait annoncé en décembre dernier que « La recherche continuera à changer profondément en 2025« .

Wait and see…

1 commentaire